- In:

- Posted By: Veronica Pesenti

- Commenti: 0

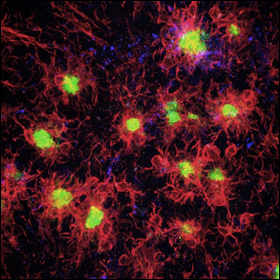

La foresta pluviale amazzonica assorbe meno carbonio del previsto

In Amazzonia i processi naturali del terreno assorbono l'equivalente di quasi un terzo delle emissioni di biossido di carbonio di combustibili fossili e industria.

Un nuovo studio ha scoperto che nei modelli di ecosistemi non è stato adeguatamente preso in considerazione l'apporto insufficiente di nutrienti.

L'agricoltura, la silvicoltura e altri tipi di utilizzo del suolo rappresentano il 23% delle emissioni di gas serra provocate dall'uomo, ma allo stesso tempo i processi naturali del terreno assorbono l'equivalente di quasi un terzo delle emissioni di biossido di carbonio di combustibili fossili e industria, secondo l’International Panel on Climate Change, che ha pubblicato il primo rapporto (1) completo in assoluto sulle interazioni tra terra e clima all'inizio di questo mese. Per quanto tempo la foresta pluviale amazzonica continuerà a fungere da efficace pozzo di assorbimento del carbonio?

Un team internazionale di scienziati, tra cui climatologi del Dipartimento dell'Energia del Lawrence Berkeley National Laboratory (Berkeley Lab), ha indagato su questa domanda e ha scoperto che i terreni carenti di fosforo hanno ridotto l'assorbimento di biossido di carbonio previsto in media del 50% in Amazzonia, rispetto alle stime attuali basate su precedenti modelli climatici che non hanno tenuto conto di questa carenza.